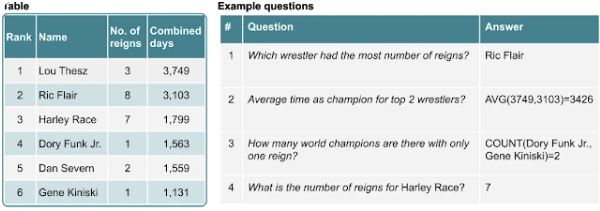

Google今天开放了一种机器学习模型的源代码,该模型可以指向电子表格和数据库中自然语言问题的答案(例如,“哪个摔跤手的统治次数最多?”)。该模型的创建者声称,它甚至能够找到分布在整个单元中的答案,或者可能需要聚合多个单元。

Google Research的托马斯·穆勒(ThomasMüller)在博客文章中指出,世界上许多信息都以表格的形式存储,例如全球金融统计数据和体育赛事结果。但是这些表格通常缺乏直观的筛选方法-Google的AI模型旨在解决这个问题。

为了处理诸如“前两名摔跤冠军的平均时间?”之类的问题,模型将对问题以及表格内容逐行编码。它利用基于Transformer的BERT架构-一种双向(允许它从过去和将来的方向访问内容)和不受监督的架构(意味着它可以摄取未分类或未标记的数据)-与称为嵌入的数字表示一起进行扩展表结构。

根据Müller的说法,关键的补充是用于对结构化输入进行编码的嵌入。列索引,行索引和一个特殊等级索引的学习嵌入向模型指示数字列中元素的顺序。

对于每个表格单元格,模型都会生成一个分数,指示该单元格将成为答案一部分的概率。另外,它输出一个操作(例如“ AVERAGE”,“ SUM”或“ COUNT”),指示必须执行哪个操作(如果有)才能产生最终答案。

为了对该模型进行预训练,研究人员从英语维基百科中提取了620万个表文本对,作为训练数据集。在预训练期间,该模型以相对较高的准确度学习了如何恢复已删除的表格和文本中的单词-对于训练期间未看到的表格,正确还原了71.4%的项目。

在进行预训练之后,Müller和团队通过弱监督对模型进行了微调,使用有限的来源提供用于标记训练数据的信号。他们报告说,最好的模型比Sequential Answering Dataset的最新技术性能好12点,Sequential Answering Dataset是Microsoft创建的用于探索表格回答问题任务的基准。它还在斯坦福大学的WikiTableQuestions上击败了之前的顶级模型,该模型包含了来自Wikipedia的问题和表格。

“薄弱的监督方案是有益的,因为它允许非专家提供训练模型所需的数据,并且比强有力的监督花费的时间更少,”Müller说。